应用

适用于机器学习系统的解决方案

适用于机器学习和推理系统的高速连接和电源连接解决方案。

如今的世界比以往任何时候都更加紧密互连,数以亿计的物联网设备彼此连接,不断生成海量数据。 经过分析提炼,数据将重新定义人们的交易、交往乃至日常生活。神经网络通过处理数据获取洞察,并以此识别模式对信息进行分类。一旦神经网络训练某个模型成熟,该模型可以用来处理和分析新的数据。这通常称为推理。语音识别、目标检测、图像分类、内容个性化和推荐引擎是可以利用推理的日常应用。

终端用户往往期待语音识别、推荐引擎等日常应用可以提供实时的见解,这使推理过程不得不在移动设备和边缘端进行。 我们可以使用不同的硬件加速器(如 FPGA、GPU 和 ASIC)来对数据进行分类和描述。这些设备在处理马力和功耗方面各不相同,根据工作负载,每种设备各有优势。某些设备可同时用于训练和推理两种用途,某些设备只能用于一种用途。

- 现场可编程逻辑门阵列 (FPGA):通常用于将网络和存储任务从 CPU 剥离,并加快网络和存储进程。

- 图形处理单元 (GPU):用于处理并发任务,可以比 CPU 更高效地处理大型数据集。

- 专用集成电路 (ASIC):是围绕特定工作负载或任务设计的处理器,可实现最佳的能效。

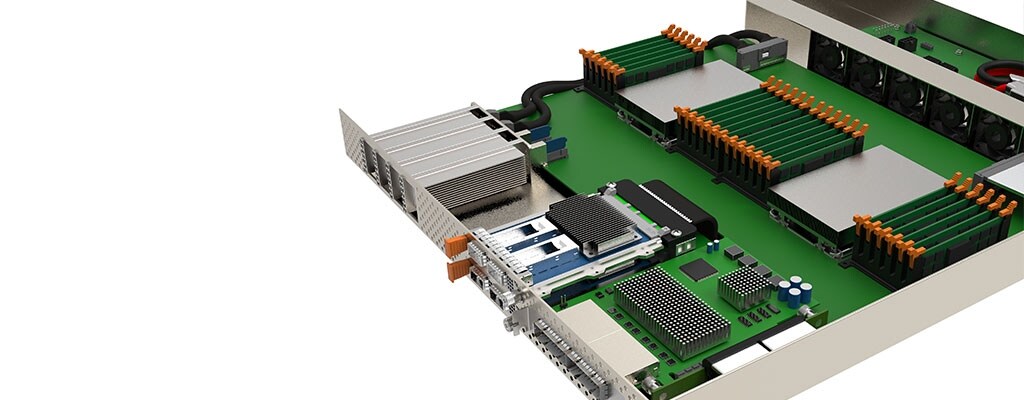

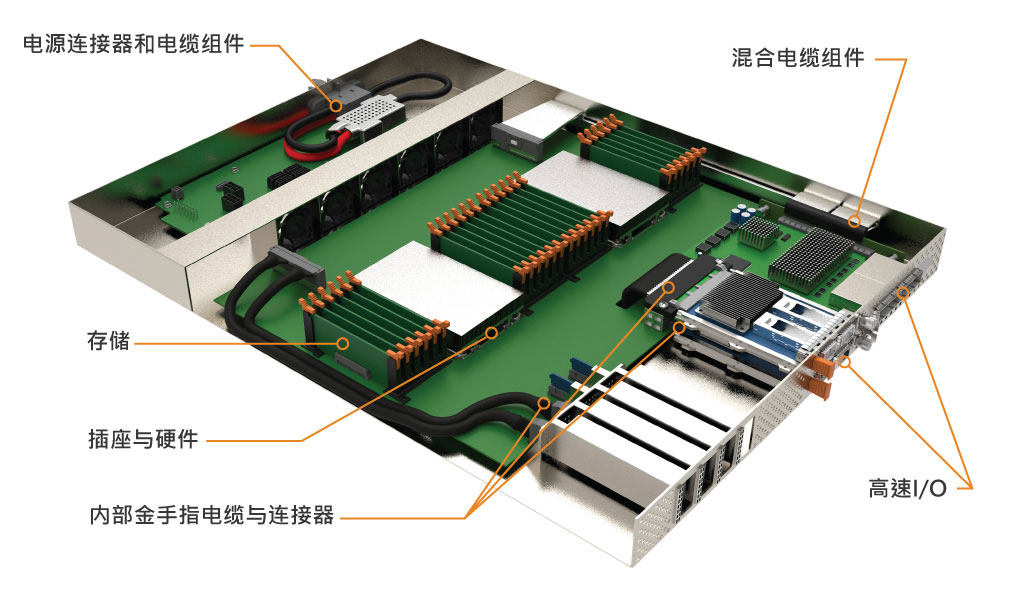

硬件加速器通常被安置在大型结构中,能够连接到其他计算、存储设备和更大的网络。 选择以太网和 InfiniBand 等协议来支持网络连接,则通常需要 OSFP 和 QSFP-DD 等高速 I/O 外形规格。再利用 PCIe 将存储设备、网络接口卡 (NIC) 和硬件加速器连接到 CPU。TE 的 Sliver 连接器和电缆系列符合 SFF-TA-1002 规范,支持设备以 PCIe Gen 5 和 Gen 6 的速度连接和运行。

Compute Express Link (CXL) 和 Gen-Z 是近两年推出并被快速采用的协议,旨在通过高速缓存一致的存储来消除内存瓶颈。这有助于创建新的架构,增加对外部 PCIe 结构的需求,而 TE 的 CDFP 和 Mini-SAS HD 等连接产品可以支持这一需求。

TE 的 STRADA Whisper 高速背板连接器和电缆系统,支持 112 Gbps PAM-4 高速传输,提供盲插连接,有助于实现系统模块化。

e

e

e

e

e

e